Apple dijo el jueves que estaba introduciendo nuevas funciones de seguridad infantil en iOS, iPadOS, watchOS y macOS como parte de sus esfuerzos para frenar la difusión de material de abuso sexual infantil (CSAM) en los Estados Unidos.

Con este fin, el fabricante del iPhone dijo que tiene la intención de comenzar a escanear imágenes compartidas a través de todos los dispositivos Apple en el lado del cliente en busca de contenido de abuso infantil conocido cuando se carguen en iCloud Photos, además de usar el aprendizaje automático en el dispositivo para escanear todos los iMessages. Imágenes enviadas o recibidas por cuentas de menores (menores de 13 años) para alertar a los padres sobre fotos sexualmente explícitas compartidas a través de la plataforma de mensajería.

Además, Apple también planea actualizar Siri y Search para que tomen medidas cuando los usuarios intenten buscar temas relacionados con CSAM, advirtiendo que «el interés en este tema es perjudicial y problemático».

«Los informes utilizan el aprendizaje automático en el dispositivo para analizar los archivos adjuntos de imágenes y determinar si la foto es sexualmente explícita», dijo Apple. «La función está diseñada para evitar que Apple acceda a las noticias». Se dice que la función llamada Seguridad de la comunicación es una configuración opcional que los padres deben habilitar a través de la función Compartir en familia.

Cómo se identifica el material de abuso sexual infantil

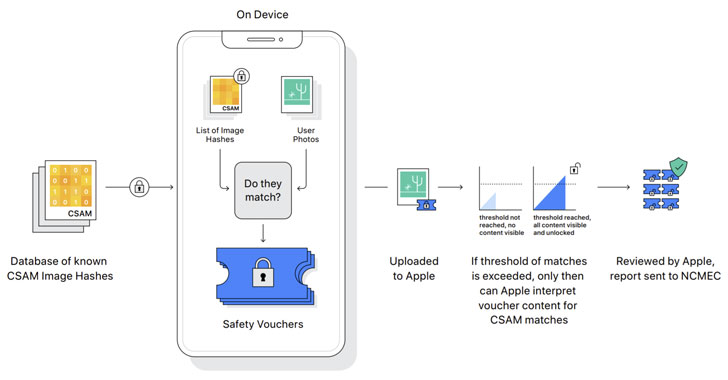

La detección de imágenes CSAM conocidas implica realizar comparaciones en el dispositivo utilizando una base de datos de hashes de imágenes CSAM conocidas proporcionadas por el Centro Nacional para Niños Desaparecidos y Explotados (NCMEC) y otras organizaciones de seguridad infantil antes de cargar fotos en la nube. «NeuralHash», como se llama el sistema, funciona con una tecnología criptográfica conocida como intersección de conjuntos privados. Sin embargo, debe tenerse en cuenta que, si bien el escaneo es automático, la función solo funciona si está activado el uso compartido de fotos en iCloud.

Además, se espera que Apple utilice otro principio criptográfico llamado umbral secreto compartido, que le permite «interpretar» el contenido si la cuenta de iCloud Photos supera el umbral de visualización de abuso infantil conocido, después de lo cual el contenido se verifica manualmente para confirmar el cumplimiento. si es así, desactive la cuenta de usuario, reporte el material al NCMEC y páselo a las autoridades policiales.

Los investigadores expresan su preocupación por la privacidad

La iniciativa CSAM de Apple ha llevado a los investigadores de seguridad a expresar su preocupación de que podría verse afectada por el avance lento de la misión, y se ha ampliado para descubrir otros tipos de contenido que podrían tener implicaciones políticas y de seguridad o incluso acosar a personas inocentes al enviarles mensajes inofensivos pero imágenes dañinas diseñadas para parecer pornografía infantil.

El denunciante estadounidense Edward Snowden tuiteó que, a pesar de las buenas intenciones del proyecto Apple, está introduciendo la «vigilancia masiva», mientras que un profesor de criptografía y experto en seguridad de la Universidad Johns Hopkins mateo verde él dijo«El problema es que el cifrado es una herramienta poderosa que brinda privacidad, y no se puede tener una privacidad realmente sólida mientras se realiza un seguimiento de cada imagen que envía cualquier persona».

Apple ya compara los archivos de correo electrónico y las imágenes en iCloud con las imágenes conocidas de abuso infantil, al igual que los gigantes tecnológicos como Google, Twitter, Microsoft, Facebook y Dropbox, que usan métodos similares de hash de imágenes para encontrar y etiquetar materiales potencialmente abusivos, pero la compañía Un intento de seguir la línea de la privacidad podría renovar los debates sobre el debilitamiento del cifrado, la intensificación de las redadas de privacidad de larga duración y la vigilancia en la era digital.

Una investigación de 2019 realizada por el New York Times reveló que en 2018 se informó un récord de 45 millones de fotos y videos en línea de niños abusados sexualmente, casi dos tercios de los cuales fueron a Facebook Messenger, siendo Facebook en su conjunto responsable de 90. % del informe.

Los cambios inminentes también significan una cara bastante desagradable para una empresa que, junto con WhatsApp, propiedad de Facebook, se ha resistido constantemente a los esfuerzos para debilitar deliberadamente el cifrado y las puertas traseras de sus sistemas. Es decir, Reuters dijo el año pasado que la compañía abandonó los planes para cifrar las copias de seguridad completas de los usuarios en iCloud en 2018 después de que la Oficina Federal de Investigaciones (FBI) de EE. UU. expresara su preocupación de que esto dificultaría la investigación.

«La explotación infantil es un problema grave y Apple no es la primera empresa de tecnología en cambiar su postura sobre la privacidad en un esfuerzo por combatirla. Pero esta elección tendrá un alto precio para la privacidad general del usuario», dijo Electronic Frontier Foundation (EFF). dijo en un comunicado que la medida de Apple podría romper la protección de cifrado y abrir la puerta a un abuso más amplio.

«Todo lo que se necesitaría para expandir las estrechas puertas traseras que Apple está construyendo es ampliar los parámetros de aprendizaje automático para encontrar otros tipos de contenido o modificar los indicadores de configuración para escanear no solo las cuentas de los niños, sino de cualquiera. No es una pendiente resbaladiza; es un sistema completamente construido. , que está a la espera de presiones externas para hacer el más mínimo cambio”, agregó.

Se espera que los esfuerzos de CSAM se implementen en los EE. UU. en los próximos meses como parte de iOS 15 y macOS Monterey, pero queda por ver si estará disponible internacionalmente o cuándo. En diciembre de 2020, Facebook se vio obligado a desactivar algunas de sus herramientas de detección de abuso infantil en Europa en respuesta a los cambios recientes en la Directiva de privacidad electrónica de la Comisión Europea, que prohíbe de manera efectiva los sistemas automáticos para escanear imágenes de abuso sexual infantil y otro contenido ilegal sin el consentimiento explícito del usuario. . .