Los investigadores han descubierto brechas en el proceso de verificación de habilidades de Amazon para el ecosistema de asistente de voz de Alexa que podría permitir que un actor malintencionado publique una habilidad engañosa con cualquier nombre de desarrollador arbitrario e incluso realizar cambios en el código de back-end después de la aprobación para engañar a los usuarios para que entreguen información confidencial.

Los hallazgos fueron presentados el miércoles en la conferencia Network and Distributed System Security Symposium (NDSS) por un grupo de académicos de Ruhr-Universität Bochum y la Universidad Estatal de Carolina del Norte, quienes analizaron 90,194 habilidades disponibles en siete países, incluidos EE. , Australia, Canadá, Alemania, Japón y Francia.

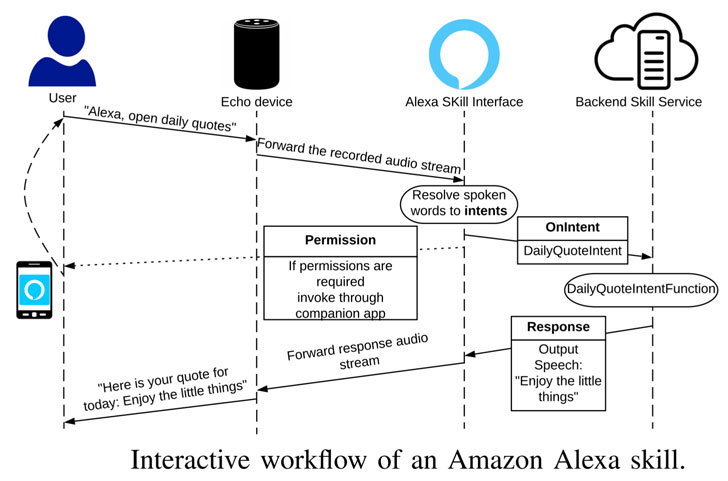

Amazon Alexa permite a los desarrolladores externos crear funcionalidades adicionales para dispositivos como los parlantes inteligentes Echo mediante la configuración de «habilidades» que se ejecutan sobre el asistente de voz, lo que facilita que los usuarios inicien una conversación con la habilidad y completen una tarea específica. .

El principal de los hallazgos es la preocupación de que un usuario pueda activar una habilidad incorrecta, lo que puede tener graves consecuencias si la habilidad que se activa está diseñada con una intención insidiosa.

El escollo surge del hecho de que varias habilidades pueden tener la misma frase de invocación.

De hecho, la práctica es tan frecuente que la investigación detectó 9948 habilidades que comparten el mismo nombre de invocación con al menos otra habilidad solo en la tienda de EE. UU. En los siete almacenes de habilidades, solo 36 055 habilidades tenían un nombre de invocación único.

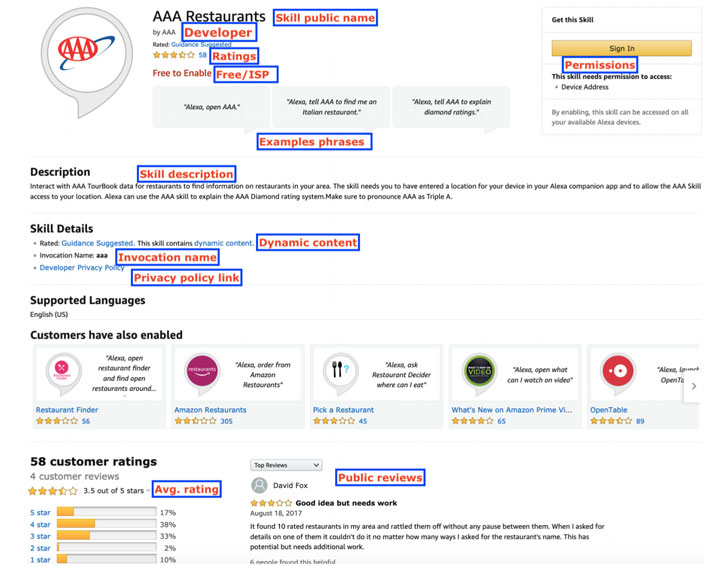

Dado que los criterios reales que usa Amazon para habilitar automáticamente una habilidad específica entre varias habilidades con los mismos nombres de invocación siguen siendo desconocidos, los investigadores advirtieron que es posible activar la habilidad incorrecta y que un adversario puede salirse con la suya usando habilidades de publicación conocidas. nombres

«Esto sucede principalmente porque Amazon actualmente no emplea ningún enfoque automatizado para detectar infracciones por el uso de marcas comerciales de terceros, y depende de la verificación manual para detectar intentos malévolos que son propensos a errores humanos», explicaron los investigadores. «Como resultado, los usuarios podrían quedar expuestos a ataques de phishing lanzados por un atacante».

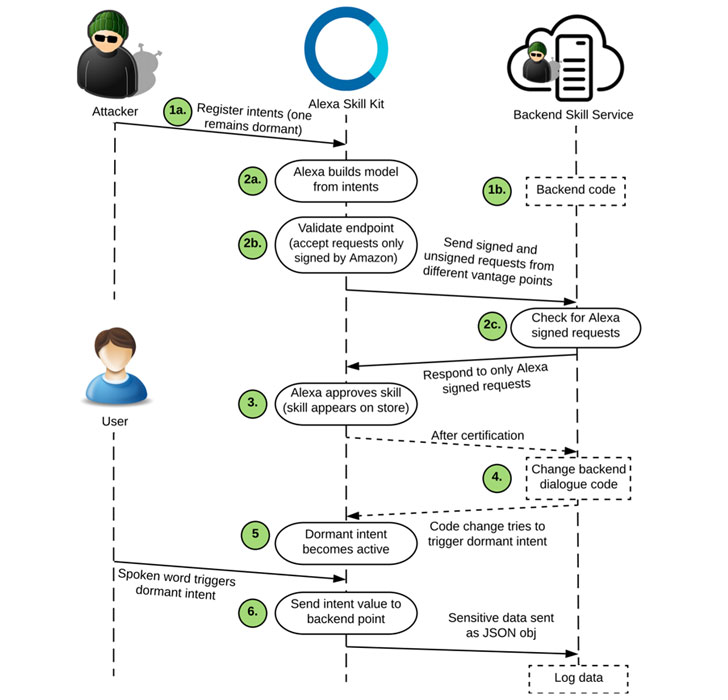

Peor aún, un atacante puede realizar cambios en el código después de la aprobación de una habilidad para convencer a un usuario de que revele información confidencial, como números de teléfono y direcciones, activando una intención latente.

En cierto modo, esto es análogo a una técnica llamada control de versiones que se usa para eludir las defensas de verificación. El control de versiones se refiere al envío de una versión benigna de una aplicación a la tienda de aplicaciones de Android o iOS para generar confianza entre los usuarios, solo para reemplazar el código base con el tiempo con funcionalidad maliciosa adicional a través de actualizaciones en una fecha posterior.

Para probar esto, los investigadores crearon una habilidad de planificador de viajes que permite a un usuario crear un itinerario de viaje que se modificó después de la verificación inicial para «pedir al usuario su número de teléfono para que la habilidad pueda enviar mensajes de texto (SMS) directamente sobre el viaje». itinerario, «engañando así al individuo para que revele su información personal.

Además, el estudio encontró que el modelo de permiso que utiliza Amazon para proteger los datos confidenciales de Alexa se puede eludir. Esto significa que un atacante puede solicitar directamente datos (por ejemplo, números de teléfono, detalles de Amazon Pay, etc.) del usuario que originalmente fueron diseñados para ser acordonados por las API de permisos.

La idea es que, si bien las habilidades que solicitan datos confidenciales deben invocar las API de permisos, eso no impide que un desarrollador deshonesto solicite esa información directamente al usuario.

Los investigadores dijeron que identificaron 358 habilidades de este tipo capaces de solicitar información que idealmente debería estar protegida por la API.

Por último, en un análisis de las políticas de privacidad en diferentes categorías, se encontró que solo el 24,2 % de todas las habilidades proporciona un enlace a la política de privacidad, y que alrededor del 23,3 % de dichas habilidades no revela completamente los tipos de datos asociados con los permisos solicitados.

Al señalar que Amazon no exige una política de privacidad para habilidades dirigidas a niños menores de 13 años, el estudio planteó preocupaciones sobre la falta de políticas de privacidad ampliamente disponibles en las categorías «niños» y «salud y estado físico».

«Como defensores de la privacidad, creemos que tanto las habilidades relacionadas con los ‘niños’ como con la ‘salud’ deben tener estándares más altos con respecto a la privacidad de los datos», dijeron los investigadores, al tiempo que instaron a Amazon a validar a los desarrolladores y realizar verificaciones de back-end recurrentes para mitigar tales riesgos.

«Si bien estas aplicaciones facilitan la interacción de los usuarios con los dispositivos inteligentes y refuerzan una serie de servicios adicionales, también aumentan las preocupaciones de seguridad y privacidad debido al entorno personal en el que operan», agregaron.